第三視角觀看世界並與之互動,與從第一視角體驗動作之間存在顯著差異,這種差異類似於從地面觀看其他人乘坐過山車,和自己乘坐過山車——最終形成的過山車體驗和理解完全不同。這是目前人工智慧 (AI) 及其應用程式所面臨的障礙。

新加坡國立大學 (NUS)和世界各地的其他 12 所大學開展合作,以開展一項長期項目——以自我為中心的 4D 實時感知 ( Egocentric 4D Live Perception, Ego4D),利用聲音和視覺線索開發具有社交智能的 AI。

Ego4D的誕生背景

為了開啟下一波人工智慧技術浪潮,為增強現實 (AR) 和機器人技術的未來助手和創新提供動力,人工智慧需要發展為以自我為中心(即第一人稱)感知的全新範式。這意味著在實時運動、交互和多感官觀察的背景下,教人工智慧通過人眼了解世界。

為此,新加坡國立大學 (NUS)和世界各地的其他 12 所大學開展合作,以開展一項長期項目——以自我為中心的 4D 實時感知 (Ego4D)。

研究方法

新加坡國立大學電氣和計算機工程系的團隊一直在積極收集第一視角數據。在 2021 年期間,研究團隊將頭戴式攝像頭和 AR 眼鏡總共分發給了當地的 40 名參與者,通過捕捉他們日常場景的平視和第一人稱視角的日常活動,例如理髮、在小販中心用餐或去健身房等,來採集數據,並根據收集到的視頻數據訓練人工智慧模型,通過利用音頻和視覺線索來理解人與人的互動。

通過在日常場景中收集第一人稱視頻數據

來源:NUS

NUS 研究團隊的助理教授 Mike Shou 說:「在過去的 10 年裡,我們見證了人工智慧以 ImageNet 等數據為基礎在圖像理解方面的革命。同樣,我相信我們的 Ego4D 數據集將為以自我為中心的視頻研究奠定必要的基礎,並推動為 AR 和機器人應用構建 AI 模型的顯著進展。」

研究應用

Ego4D的進步將為人工智慧開發更為先進的認知能力提供必要的基本構建模塊。事實證明,此類 AI 助手將在我們的日常生活和工作中發揮更大作用。想像一下:在嘗試烹飪新食譜時,與其反覆參考食譜並嘗試,不如戴上一副 AR 智能眼鏡,即可指導做菜的每個特定步驟,就好像有一位大廚在旁邊指導。

Mike Shou教授解釋說:「對於新加坡及其老齡化人口而言,這樣的人工智慧助手可以為老年人提供特殊的幫助,尤其是那些患有痴呆症或阿爾茨海默氏症等健康問題的人。一副 AR 眼鏡可以幫助老年患者記住什麼時候發生了什麼事,幫助他們記得把鑰匙放在哪裡,或者是否記得鎖門等問題。應用於醫療保健的人工智慧助手還可以同時照顧一個病房中的多名患者。」

以第一人稱和第三人稱視角收集的視頻數據示例

來源:NUS

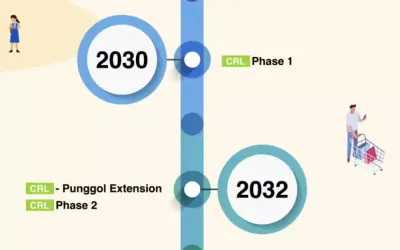

研究進展

新加坡國立大學團隊與其合作夥伴共同收集了來自九個國家的 700 多名研究參與者的超過 3,000 小時的第一人稱視頻數據,將用於Ego4D的日常訓練。Ego4D 是一個大規模的以自我為中心視角的日常生活活動視頻數據集,涵蓋全球 73 個地點,在場景、人物和活動方面提供了更多的多樣性,可以提高針對不同背景、種族、職業和年齡的AI 模型的適用性。

Ego4D 學術聯盟數據收集來源圖

來源:NUS

這個首創的視頻數據集捕捉了相機佩戴者在特定環境中注視的內容,相機佩戴者用手和面前的物體的互動,以及相機佩戴者如何與他人互動。不同文化和地理環境的體驗會有很大差異。NUS 團隊收集的數據可以代表東南亞人口。

與數據收集同樣重要的是,定義正確的任務,進行嚴格的人工標註,來引導新技術的研發。

為此,Ego4D 學術聯盟聯合構建了五個全新的、具有挑戰性的任務:

(1) 情景記憶:什麼時候發生了什麼?例如告訴我錢包最近一次出現的位置。

(2) 預測未來:我接下來要做什麼?例如下一步要去廚房煮麵。

(3) 手與物體交互:我在做什麼以及如何做?

(4) 視覺+聽覺:多人場景下,誰在什麼時候說了什麼?例如會議紀要。

(5) 社交交互:人與人如何互動?

「我們NUS研究團隊主要為其中兩個關鍵任務開發模型:一是,利用聲音和視覺線索幫助AI識別「誰在什麼時候說了什麼;二是,開發具有社交智能的 AI,檢測當下誰在對誰說話,誰在關注誰。」同樣來自NUS團隊的Co-PI Li Haizhou教授說。

Ego4D數據集只是起點,研發第一視角AI技術將在不遠的將來,改變我們的生活、工作、娛樂方式,帶給我們前所未有的虛擬與現實交融的體驗。